20 Teknoloji Şirketi, Seçmenleri Yanıltmaya Yönelik AI Üretilmiş Ses, Video ve Görüntüler Gibi İçerikleri Tespit Etmek ve Engellemek İçin İşbirliği Yapacaklarını Duyurdu.

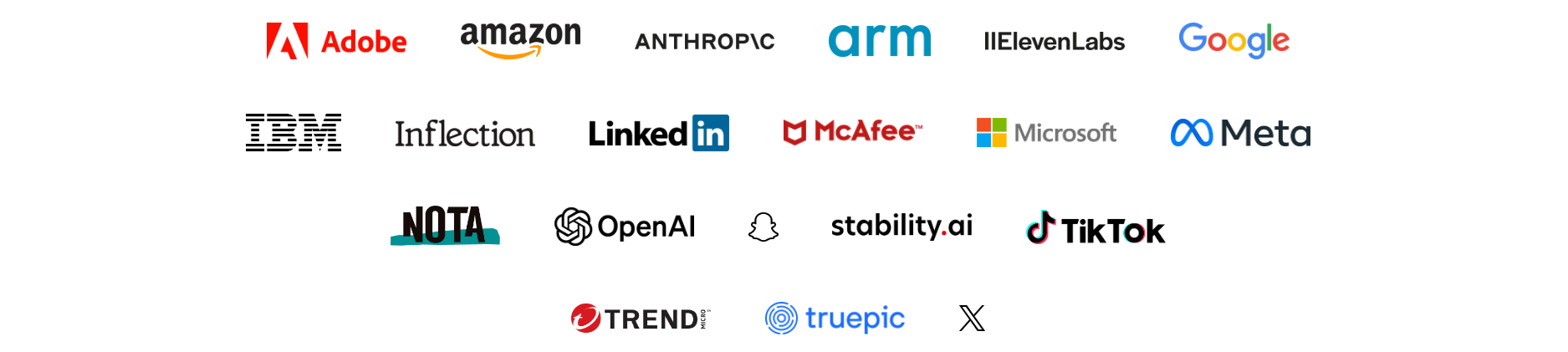

Teknoloji devleri, 2024 seçimlerinde yapay zeka kullanılarak seçmenleri yanıltmaya yönelik içeriklere karşı mücadele etmek için bir anlaşma imzaladı. 20 Önde gelen teknoloji şirketi, seçmenleri yanıltmaya yönelik AI üretilmiş ses, video ve görüntüler gibi içerikleri tespit etmek ve engellemek için işbirliği yapacaklarını duyurdu. 17 Şubat 2024 tarihinde, 60. Münih Güvenlik Konferansı’nda (MSC 2024) imzalanan bu anlaşma ‘’2024 Seçimlerinde Yapay Zekanın Aldatıcı Kullanımıyla Mücadeleye Yönelik Teknoloji Anlaşması’’ olarak adlandırıldı.

Anlaşmaya göre, şirketler, siyasi adayların, seçim görevlilerinin veya demokratik bir seçimdeki diğer önemli paydaşların görünüşünü, sesini veya eylemlerini sahte veya değiştirerek oluşturulan veya seçmenlere oy verme şekilleri hakkında yanlış bilgi veren yapay zeka ile üretilmiş ses, video ve görüntüler gibi zararlı içerikleri tespit etmek ve engellemek için teknoloji geliştirecek ve işbirliği yapacaklar.

Anlaşma, şirketlerin aşağıdaki yedi ilkeye göre hareket etmelerini taahhüt etmelerini içermektedir:

- Önleme: Şirketler, zararlı AI içeriklerinin oluşturulmasını önlemek için araştırma, yatırım ve önlemler alacaklardır.

- Kaynak: Şirketler, içeriğin kaynağını belirlemek için uygun ve teknik olarak mümkün olduğu durumlarda kaynak sinyalleri ekleyeceklerdir.

- Tespit: Şirketler, zararlı AI içeriklerini veya kimliği doğrulanmış içerikleri platformlar arasında kaynak sinyallerini okuyarak veya diğer yöntemlerle tespit etmeye çalışacaklardır.

- Duyarlı Koruma: Şirketler, zararlı AI içeriklerinin oluşturulması ve yayılmasıyla ilgili olaylara hızlı ve orantılı yanıtlar vereceklerdir.

- Değerlendirme: Şirketler, zararlı AI içerikleriyle başa çıkma deneyimlerini ve sonuçlarını değerlendirmek ve bunlardan ders çıkarmak için ortak çaba sarf edeceklerdir.

- Kamu Bilinci: Şirketler, kamuoyunu, zararlı AI içeriklerine ilişkin en iyi medya okuryazarlığı uygulamaları ve vatandaşların kendilerini bu içeriklerden koruyabilecekleri yöntemler konusunda eğitmek için ortak çabalarda bulunacaklardır.

- Dayanıklılık: Şirketler, yapay zeka okuryazarlığı ve diğer kamu programları, yapay zeka tabanlı çözümler veya bağlamsal özellikler gibi savunma araç ve kaynaklarının geliştirilmesi ve kullanıma sunulmasına yönelik çabaları destekleyeceklerdir.

Bu anlaşmayı imzalayan 20 teknoloji şirketinin tam listesi ise şöyle: Adobe, Amazon, Anthropic, Arm, ElevenLabs, Google, IBM, Inflection AI, LinkedIn, McAfee, Meta, Microsoft, Nota, OpenAI, Snap, Stability AI, TikTok, Trend Micro, Truepic ve X

Bu anlaşma, zararlı AI içeriklerine karşı çevrimiçi toplulukları korumak için önemli bir adımdır ve şirketlerin devam eden çalışmalarına dayanmaktadır. Bu yıl 40’tan fazla ülkede dört milyardan fazla insanın oy kullanacağı küresel seçimlerde, seçmenleri yanıltmaya çalışan AI içeriklerinin müdahalesini önlemek için acil bir ihtiyaç vardır.

Zararlı Yapay Zeka İçerikleri Nedir Ve Nasıl Oluşturulur?

Zararlı AI içerikleri, yapay zeka kullanılarak gerçek olmayan veya değiştirilmiş ses, video ve görüntüler oluşturmak için kullanılan bir terimdir. Bu içerikler, gerçek kişilerin veya olayların yerine geçerek veya onları taklit ederek, seçmenleri yanlış yönlendirmek, korkutmak, manipüle etmek veya karalama kampanyası yapmak amacıyla kullanılabilir.

Zararlı AI içerikleri oluşturmak için kullanılan teknolojilerden biri, derin sahte (deepfake) olarak bilinen bir yöntemdir. Derin sahte, bir kişinin yüzünü veya sesini, başka bir kişinin yüzüne veya sesine aktarmak için derin öğrenme (deep learning) adı verilen bir AI alt dalını kullanır. Derin sahte, örneğin, bir siyasi liderin, gerçekte söylemediği bir şeyi söylediği veya yaptığı bir videoyu oluşturmak için kullanılabilir.

Derin sahte dışında, diğer AI teknolojileri de zararlı AI içerikleri oluşturmak için kullanılabilir. Örneğin, nöral ağlar (neural networks), gerçek olmayan kişilerin veya nesnelerin fotoğraflarını veya videolarını üretebilir. Nöral ağlar, aynı zamanda, gerçek kişilerin veya nesnelerin fotoğraflarını veya videolarını değiştirmek veya iyileştirmek için de kullanılabilir.

Zararlı AI İçeriklerine Karşı Nasıl Korunabiliriz?

Zararlı AI içeriklerine karşı korunmak için, hem teknoloji şirketlerinin hem de bireylerin sorumluluk alması gerekmektedir. Teknoloji şirketleri, zararlı AI içeriklerini tespit etmek ve engellemek için gelişmiş teknolojiler kullanmalı, bu içerikleri yayınlayan veya paylaşan hesapları kapatmalı, bu içeriklerin kaynağını ve amacını ortaya çıkarmak için araştırma yapmalı ve kamuoyunu bilgilendirmeli ve eğitmelidir.

Bireyler ise, karşılaştıkları ses, video ve görüntülerin gerçekliğini sorgulamalı, bu içeriklerin kaynağını ve güvenilirliğini araştırmalı, bu içerikleri paylaşmadan önce doğrulamalı ve bu içeriklere karşı duyarlılık ve farkındalık geliştirmelidir. Ayrıca, bireyler, kendi yüzlerinin, seslerinin veya kişisel bilgilerinin zararlı yapay zeka içerikleri oluşturmak için kullanılmasını önlemek için, gizlilik ayarlarına dikkat etmeli ve izinsiz kullanımlara karşı hukuki yollara başvurmalıdır.

Diğer Trendler!

> Sıradaki Trend!